Minulý týždeň novozvolená americká reprezidentka Alexandria Ocasio-Cortez urobila titulky, keď v rámci štvrtého výročného podujatia MLK Now uviedla, že technológie a algoritmy na rozpoznávanie tváre „majú vždy preložené tieto rasové nerovnosti, pretože algoritmy sa stále vyrábajú. ľudskými bytosťami a tieto algoritmy sú stále naviazané na základné ľudské predpoklady. Sú iba automatizované. A automatizované predpoklady - ak neopravíte zaujatosť, potom iba automatizujete zaujatosť. ““

Znamená to, že algoritmy, ktoré sú teoreticky založené na objektívnych pravdách matematiky, môžu byť „rasistické“? A ak áno, čo sa dá urobiť na odstránenie tohto zaujatosti?

Ukazuje sa, že výstup z algoritmov môže skutočne priniesť skreslené výsledky. Vedci údajov hovoria, že počítačové programy, neurónové siete, algoritmy strojového učenia a umelá inteligencia (AI) fungujú, pretože sa učia, ako sa správať z údajov, ktoré dostávajú. Softvér píšu ľudia, ktorí majú zaujatosť, a údaje o školeniach generujú aj ľudia, ktorí majú zaujatosť.

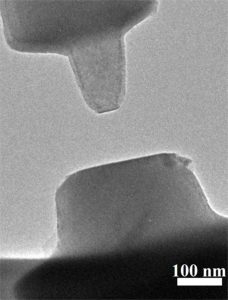

Dve fázy strojového učenia ukazujú, ako sa táto predpojatosť môže preniknúť do zdanlivo automatizovaného procesu. V prvej fáze, vo výcvikovej fáze, sa algoritmus učí na základe súboru údajov alebo na základe určitých pravidiel alebo obmedzení. Druhou fázou je inferenčná fáza, v ktorej algoritmus aplikuje to, čo sa naučil v praxi. Táto druhá fáza odhaľuje skreslenie algoritmu. Napríklad, ak je algoritmus vyškolený s obrázkami iba žien, ktoré majú dlhé vlasy, bude si myslieť, že niekto s krátkymi vlasmi je muž.

Google sa nechvalne zapálil v roku 2015, keď služba Fotky Google označila čiernych ľudí za gorily, pravdepodobne preto, že to boli jediné bytosti tmavej pleti v tréningovej sade.

A zaujatosť sa môže vplížiť cez mnoho ciest. „Bežnou chybou je školenie algoritmu na vytváranie predpovedí na základe minulých rozhodnutí zaujatých ľudí,“ uviedla spoločnosť Live Science Sophie Searcy, vedúca vedkyňa údajov v bootcampe Metis pre vzdelávanie v oblasti vedy. „Ak urobím algoritmus na automatizáciu rozhodnutí, ktoré predtým urobila skupina úverových dôstojníkov, mohol by som ísť ľahkou cestou a vycvičiť algoritmus na predchádzajúce rozhodnutia týchto úverových úradníkov. Ale potom, samozrejme, ak boli títo úveroví dôstojníci zaujatí, potom algoritmus, ktorý budujem, bude pokračovať v týchto predpojatostiach. ““

Searcy citovala príklad COMPAS, prediktívneho nástroja používaného v celom systéme trestného súdnictva USA na odsúdenie, ktorý sa snaží predpovedať, kde k zločinu dôjde. Spoločnosť ProPublica vykonala analýzu spoločnosti COMPAS a zistila, že po kontrole ďalších štatistických vysvetlení tento nástroj nadhodnotil riziko recidívy čiernych obžalovaných a dôsledne podhodnocoval riziko bielych obžalovaných.

V snahe pomôcť v boji proti algoritmickým predsudkom Searcy povedal spoločnosti Live Science, inžinieri a vedci údajov by mali zostavovať rozmanitejšie súbory údajov pre nové problémy a snažiť sa pochopiť a zmierniť skreslenie zabudované do existujúcich súborov údajov.

V prvom rade, inžinieri Ira Cohen, vedecký pracovník v analytickej spoločnosti Anodot, by mali mať školiaci set s relatívne rovnomerným zastúpením všetkých typov populácie, ak trénujú algoritmus na identifikáciu etnických alebo rodových atribútov. „Je dôležité predstaviť dostatok príkladov z každej skupiny obyvateľov, aj keď sú v skúmanej populácii menšinou,“ povedal Cohen pre Live Science. Nakoniec Cohen odporúča skontrolovať zaujatosť na testovacej sade, ktorá zahŕňa ľudí zo všetkých týchto skupín. „Ak je presnosť pre určitú rasu štatisticky výrazne nižšia ako v iných kategóriách, algoritmus môže mať predpojatosť a vyhodnotil by som údaje o tréningu, ktoré sa preň použili,“ povedal Cohen pre LiveScience. Napríklad, ak algoritmus dokáže správne identifikovať 900 z 1 000 bielych tvárí, ale správne zistí iba 600 z 1 000 ázijských tvárí, algoritmus môže mať predpojatosť „voči“ Ázijcom, dodal Cohen.

Odstránenie zaujatosti môže byť pre AI neuveriteľne náročné.

Dokonca ani Google, považovaný za predchodcu komerčnej umelej inteligencie, zrejme nemohol prísť s komplexným riešením svojho gorilého problému od roku 2015. Wired zistil, že namiesto toho, aby si našiel spôsob, ako svoje algoritmy rozlíšiť medzi ľuďmi farby a gorily, Google jednoducho zablokoval jeho algoritmy na rozpoznávanie obrázkov z identifikácie goríl vôbec.

Príkladom spoločnosti Google je dobrá pripomienka, že školenie softvéru AI môže byť náročné cvičenie, najmä ak softvér nie je testovaný ani školený zástupcom a rozmanitou skupinou ľudí.